购物车中还没有商品,赶紧选购吧!

下载日志,再使用工具editplus打开日志

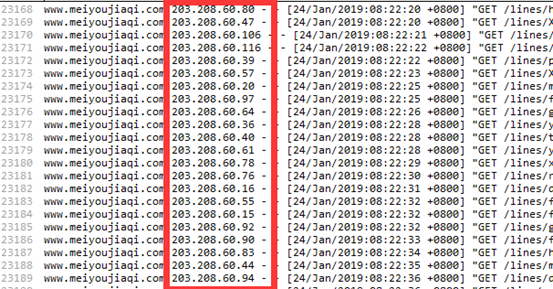

一、查看有没有大量重复访问的IP

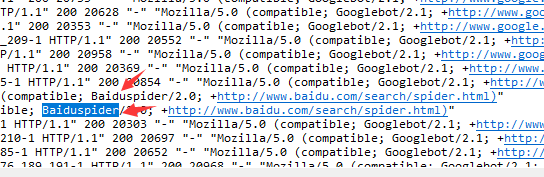

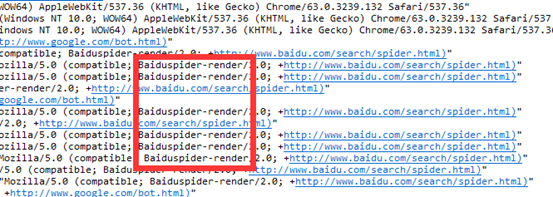

一般这种IP都是搜索引擎抓取IP段,比如谷歌蜘蛛抓取(Googlebot),百度蜘蛛抓取(Baiduspider、Baiduspider-render)。

注意:Baiduspider-render是访问网站的 CSS、Javascript 和图片信息。

如果查看到这个蜘蛛出现的次数很多,而客户网站图片又比较大,则消耗的流量就会增加,建议把图片处理小。

IP段:

谷歌蜘蛛(Googlebot):

百度蜘蛛(Baiduspider):

百度蜘蛛(Baiduspider-render):

针对以上的异常蜘蛛抓取,处理方法如下:

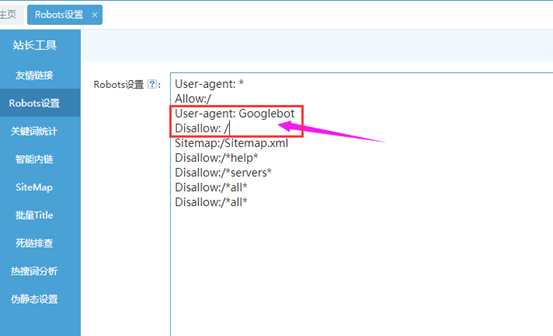

1、在后台robots禁止谷歌抓取

User-agent: Googlebot

Disallow: /

参考位置,加在这里:

2、调低百度蜘蛛抓取频率。

登陆百度站长调整。

3、还有个方法,就是帮屏蔽这些抓取IP(仅限客户自有服务器)。

二、移动端抓取

思途cms系统,后台做的robots屏蔽仅针对PC端,手机端没做。

但可以把robots屏蔽里面的代码另存为txt文档,上传到服务器手机端根目录下。

主要就是1、2点,屏蔽搜索引擎的大量抓取,再观察后续流量是否降低。

其他处理(针对网站优化)

三、屏蔽列表页抓取

为什么要屏蔽搜索引擎抓取列表页?

原因:列表页url很长,收录也没内容,对于排名没作用,还会分散权重

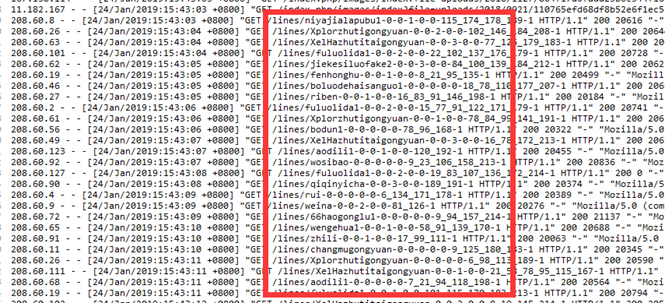

看日志里,搜索引擎访问的页面链接地址,分辨列表页:

以上这些就是列表页,可以看到搜索引擎抓取了很多列表页。

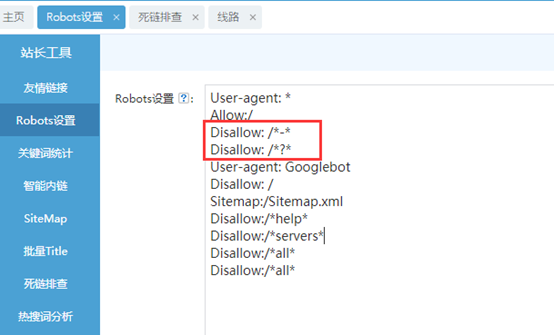

Disallow: /*-*

Disallow: /*?*

用这段代码,屏蔽搜索引擎抓取列表页。

可以加在这个位置:

四、处理404页面

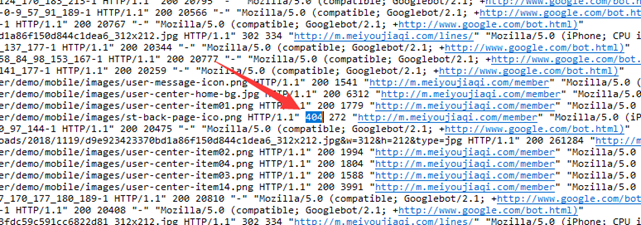

访问日志中如看到大量404页面,就要去百度站长提交处理死链

在HTTP/1.1 后面,是404就表示访问的页面已经不在了,死页面,要处理;

后面显示200,就表示正常抓取,页面存在

其他要点:

在网址后面+robots.txt 可以不登录后台就看到它的robots设置。

小米

小米

会员评论