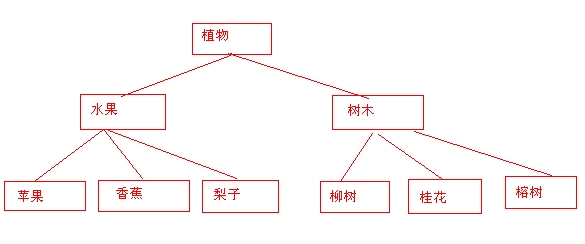

了解过搜索引擎爬虫抓取爬行的可能会有一个比较清晰的答案,是的就是帮助爬虫尽可能的抓取页面,只有被读取到的页面才有可能被收录。

扁平化的结构将网站的页面尽可能的直接展示在蜘蛛爬虫面前或者很容易被爬虫发现,不需要一个层级一个层级的深入挖掘,除非知名站点或大型网站能够享有这种特权。因为整个互联网的数据量是相当庞大的,而每天更新的信息量现有的蜘蛛资源都很难去实现完全抓取,还有些页面每天会被蜘蛛重复抓取,所以这就需要蜘蛛舍弃一些,所以也就出现了抓取策略,对低质量的网站降低抓取量,很难发现新页面的网站将资源全都消耗在页面的重复抓取上面。

赞

5

有一点帮助

1

没有帮助

小米

小米